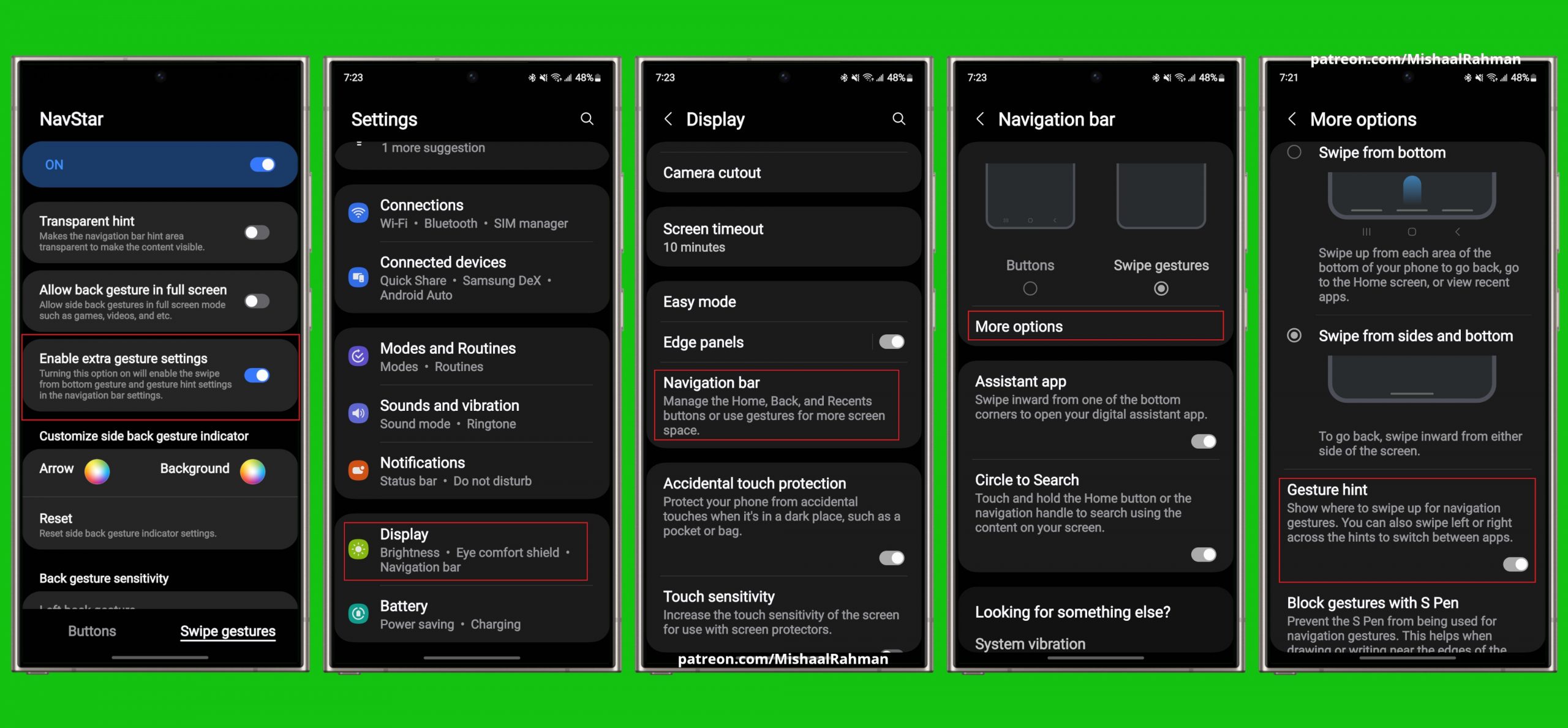

Ollama + Enchanted = lokale LLM-Sprachmodelle auch unterwegs

Quelle: Augustinas Malinauskas Ollama installiert auf eurem Mac ein lokales (Offline-/Open-Source-)LLM – von Mistral, über Llama bis DeepSeek. Über ngrok wird die lokale Adresse („localhost:11434“) außerhalb des eigenen Netzwerks erreichbar. Hinterlegt ihr die euch temporär zugeteilte „Forwarding URL“ in der App-Store-App Enchanted (GitHub), benutzt ihr das iPhone um eure Fragen an die lokalen Sprachmodelle auszuführen undweiterlesen

Quelle: Augustinas Malinauskas

Ollama installiert auf eurem Mac ein lokales (Offline-/Open-Source-)LLM – von Mistral, über Llama bis DeepSeek.

Über ngrok wird die lokale Adresse („localhost:11434“) außerhalb des eigenen Netzwerks erreichbar. Hinterlegt ihr die euch temporär zugeteilte „Forwarding URL“ in der App-Store-App Enchanted (GitHub), benutzt ihr das iPhone um eure Fragen an die lokalen Sprachmodelle auszuführen und anzuzeigen, ohne dabei aber vor dem Mac zu sitzen.

Wenn du Artikel wie diesen magst, unterstütze mich doch mit einem Abo für iPhoneBlog #one. Alle Abonnent:innen erhalten jede Woche ein exklusives „Gewusst-wie”-Video, den Zugriff auf alle schon veröffentlichten Episoden sowie die Einladung zu einer ganz besonderen Community in einem privaten Slack-Kanal.