Повтор балета R1 в исполнении simpleRL-reason.

Интересный момент в истории, я не успеваю закупать семечки (российкий аналог попкорна), ибо столкнулось сразу два мнения про роль RL в AI, там "движенья нет, сказал мудрец -- другой вдруг встал и стал пред ним ходить", а теоретики говорят, что движенья и не может быть. Вот тут два месяца вели примерно те же эксперименты, что DeepSeek с R1 (при этом DeepSeek успело опубликоваться раньше!), результаты у этого проекта simpleRL-reason примерно те же, кто у проекта R1 -- если правильно учить, то нейросетка сама научается думать подольше -- и саморефлексировать в ходе этого думания. Важно, что для выхода на SoTA надо x50 меньше данных! Вот: https://hkust-nlp.notion.site/simplerl-reason (вот где это обсуждается -- https://x.com/junxian_he). При этом напоминают, что полная R1 имеет до чёртиков параметров -- и может соревноваться с o1 и Gemini. Гугль хвастается, что Gemini 2.0 Flash Thinking (01-21) и на первом месте на арене, и 1млн окно контекста, и дешевле R1 (экспоненты работают тут очень лихо, смотрите график эволюции силы моделей и их стоимости -- https://x.com/raveeshbhalla/status/1883380722645512275), но скромно умалчивает про открытость весов и стоимость обучения, американцы настаивают, что никакой китай их не обгонит, и США -- родина всех слонов, им возражают, то SGD и CNN из Франции, stable diffusion из Германии, ViT частично из Швейцарии, и т.д. (https://x.com/JFPuget/status/1883517095465414724), продолжают там ролью Канады (начиная с GANs, https://x.com/jm_alexia/status/1883537142984700049), а ещё вдруг США припомнили бум доткомов и отсутствие нормальной конкуренции сегодня -- creativity of U.S. startups during the dot-com boom — which spawned 2,888 initial public offerings (compared to zero IPOs for U.S. generative AI startups). . Шороху навелось много (включая огромное число конспиративных теорий, но их опустим), но факт: RL, даже не слишком навороченный, может обучать нейросетку "думать подольше" и критиковать свои же начальные догадки, поэтому не нужно огромного числа входных данных, можно обходиться x50 меньше (и соответственно уменьшать стоимость обучения), а ещё слухи о полезности синтетических данных оказываются сильно преувеличенными в этой связи.Прямо в это же время выходит новая работа людей из open-endedness тусовки (Lehman, Stanley, и все-все) https://arxiv.org/abs/2501.13075 "Evolution and The Knightian Blindspot of Machine Learning", в которой даётся отсылка к Knightian uncertainty (в экономике это различение риска -- знание того, что могло бы произойти, от полного незнания того, что могло бы произойти -- https://en.wikipedia.org/wiki/Knightian_uncertainty). Делается утверждение, что AI сегодня на базе RL -- это исключительно оптимизация для известного (поиск локального максимума), а не эволюционный/меметический алгоритм, который мог бы приспособиться к полностью неизвестному. Доказательства: "автомобиль, выученный водить в США, не сможет водить в Великобритании, а вот люди -- вполне справляются". Ну, и дальше в примерах там эволюция, а спасёт всех open-endedness. И вроде бы не поспоришь, но там два направления ответа: оказывается, нейросетка может и самообучиться эволюционному алгоритму (как показывают работы по RL для обучения языковых моделей по R1 и SimpleRL-reason), внутри нейросетки работает эволюционный алгоритм, и даже в латентном пространстве (например, работа https://arxiv.org/abs/2112.10752, обзор на русском https://t.me/gonzo_ML/3027, и я бы добавил сюда ещё ход на работу в латентном пространстве по тем же CoT от META, coconut, continuous thougts -- https://arxiv.org/abs/2412.06769). Тем самым "всё правильно, предсказать нельзя, реальный мир бесконечно разнообразен" -- но "при этом RL тут не при чём, вы просто не умеете его готовить, надо просто меметическому алгоритму сетку научить, а для рассуждений использовать непрерывные мысли". И тут же пример работы с хлёстким заголовком "Simulating 500 million years of evolution with a language model", https://www.biorxiv.org/content/10.1101/2024.07.01.600583v2.full.pdf -- где белковая LLM предложила флуоресцентный белок такой структуры, который от нынешних белков отстоит на 500 миллионов лет эволюции (цифра получена стандартным на сегодня расчётом). И тут же выходит теоретическая работа, которые показывают ограничения нейросетевых структур, тоже от эволюционистов, Michael Levin со товарищи, "Topological constraints on self-organisation in locally interacting systems", https://arxiv.org/abs/2501.13188, we have demonstrated that current natural language processing algorithms lack the necessary topology for self-organisation. This limitation explains their inability to generate long and coherent text that matches the complexity and consistency of biological systems. The key insight of ourresults is that topology is the critical factor differentiating these systems. Whilst cells in the human body can coordinate and organise over large scales, forming coherent tissues and organs, language models struggle to maintain consistency beyond thei

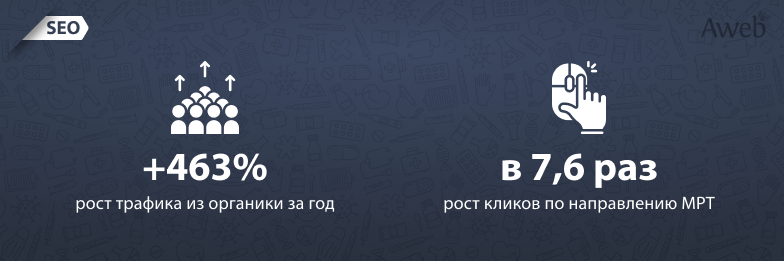

Вот тут два месяца вели примерно те же эксперименты, что DeepSeek с R1 (при этом DeepSeek успело опубликоваться раньше!), результаты у этого проекта simpleRL-reason примерно те же, кто у проекта R1 -- если правильно учить, то нейросетка сама научается думать подольше -- и саморефлексировать в ходе этого думания. Важно, что для выхода на SoTA надо x50 меньше данных! Вот: https://hkust-nlp.notion.site/simplerl-reason (вот где это обсуждается -- https://x.com/junxian_he). При этом напоминают, что полная R1 имеет до чёртиков параметров -- и может соревноваться с o1 и Gemini. Гугль хвастается, что Gemini 2.0 Flash Thinking (01-21) и на первом месте на арене, и 1млн окно контекста, и дешевле R1 (экспоненты работают тут очень лихо, смотрите график эволюции силы моделей и их стоимости -- https://x.com/raveeshbhalla/status/1883380722645512275), но скромно умалчивает про открытость весов и стоимость обучения, американцы настаивают, что никакой китай их не обгонит, и США -- родина всех слонов, им возражают, то SGD и CNN из Франции, stable diffusion из Германии, ViT частично из Швейцарии, и т.д. (https://x.com/JFPuget/status/1883517095465414724), продолжают там ролью Канады (начиная с GANs, https://x.com/jm_alexia/status/1883537142984700049), а ещё вдруг США припомнили бум доткомов и отсутствие нормальной конкуренции сегодня -- creativity of U.S. startups during the dot-com boom — which spawned 2,888 initial public offerings (compared to zero IPOs for U.S. generative AI startups). . Шороху навелось много (включая огромное число конспиративных теорий, но их опустим), но факт: RL, даже не слишком навороченный, может обучать нейросетку "думать подольше" и критиковать свои же начальные догадки, поэтому не нужно огромного числа входных данных, можно обходиться x50 меньше (и соответственно уменьшать стоимость обучения), а ещё слухи о полезности синтетических данных оказываются сильно преувеличенными в этой связи.

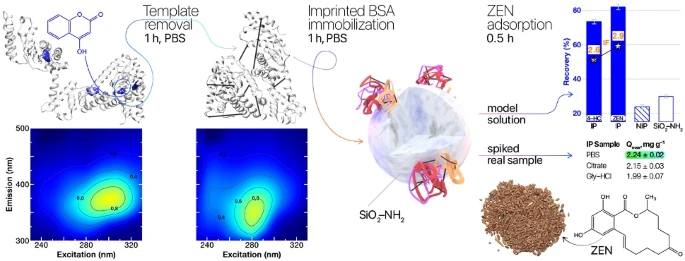

Прямо в это же время выходит новая работа людей из open-endedness тусовки (Lehman, Stanley, и все-все) https://arxiv.org/abs/2501.13075 "Evolution and The Knightian Blindspot of Machine Learning", в которой даётся отсылка к Knightian uncertainty (в экономике это различение риска -- знание того, что могло бы произойти, от полного незнания того, что могло бы произойти -- https://en.wikipedia.org/wiki/Knightian_uncertainty). Делается утверждение, что AI сегодня на базе RL -- это исключительно оптимизация для известного (поиск локального максимума), а не эволюционный/меметический алгоритм, который мог бы приспособиться к полностью неизвестному. Доказательства: "автомобиль, выученный водить в США, не сможет водить в Великобритании, а вот люди -- вполне справляются". Ну, и дальше в примерах там эволюция, а спасёт всех open-endedness. И вроде бы не поспоришь, но там два направления ответа: оказывается, нейросетка может и самообучиться эволюционному алгоритму (как показывают работы по RL для обучения языковых моделей по R1 и SimpleRL-reason), внутри нейросетки работает эволюционный алгоритм, и даже в латентном пространстве (например, работа https://arxiv.org/abs/2112.10752, обзор на русском https://t.me/gonzo_ML/3027, и я бы добавил сюда ещё ход на работу в латентном пространстве по тем же CoT от META, coconut, continuous thougts -- https://arxiv.org/abs/2412.06769). Тем самым "всё правильно, предсказать нельзя, реальный мир бесконечно разнообразен" -- но "при этом RL тут не при чём, вы просто не умеете его готовить, надо просто меметическому алгоритму сетку научить, а для рассуждений использовать непрерывные мысли". И тут же пример работы с хлёстким заголовком "Simulating 500 million years of evolution with a language model", https://www.biorxiv.org/content/10.1101/2024.07.01.600583v2.full.pdf -- где белковая LLM предложила флуоресцентный белок такой структуры, который от нынешних белков отстоит на 500 миллионов лет эволюции (цифра получена стандартным на сегодня расчётом).

И тут же выходит теоретическая работа, которые показывают ограничения нейросетевых структур, тоже от эволюционистов, Michael Levin со товарищи, "Topological constraints on self-organisation in locally interacting systems", https://arxiv.org/abs/2501.13188, we have demonstrated that current natural language processing algorithms lack the necessary topology for self-organisation. This limitation explains their inability to generate long and coherent text that matches the complexity and consistency of biological systems. The key insight of our

results is that topology is the critical factor differentiating these systems. Whilst cells in the human body can coordinate and organise over large scales, forming coherent tissues and organs, language models struggle to maintain consistency beyond their limited context windows. This disparity stems directly from the underlying topology of interactions in these systems. Картинки там интересные, про многоуровневость всё вроде хорошо и правильно в живых системах, но вот опять-таки, с демонстрациями инженеров текущих LLM пока не бьётся (ибо не учитывает тамошние "наложенные структуры", которые собираются из простых. Ну вот как говорить, что "из молекул трактора не сделаешь". Из молекул, из графа -- нет, не сделаешь. Но сетки -- это вам не граф, нейроны нелинейны, и с памятью, и хитро связаны, и там внутри много чего интересного появляется). Тем не менее, там есть интересные заявления, вроде "Text generation in analogy to a morphogenetic process", "error correction and text completion is analog to regeneration". И указание на то, что в более-менее эффективных системах должна таки быть многоуровневость (инкапсуляция функций внутри модулей с границами).

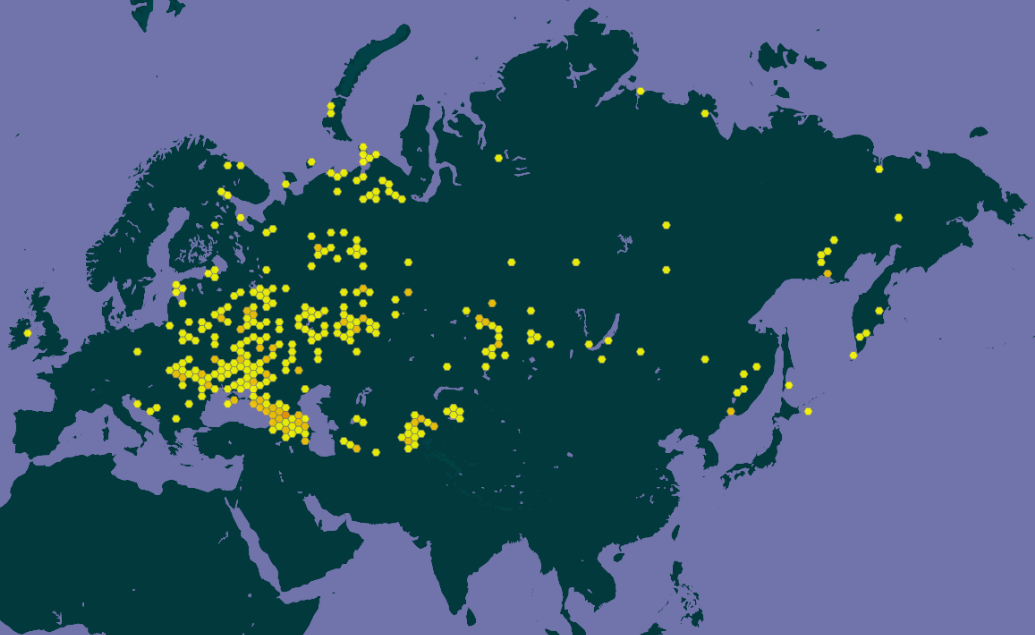

Выложил слайды (https://disk.yandex.ru/i/w2ikhzayzpUI8Q) для сегодняшнего вебинара, там на восьмом слайде пара картинок из ссылок сегодняшнего поста: