Qué fue de ATI: de mirar cara a cara a NVIDIA a acabar devorada y olvidada por la industria de la tecnología

AMD y NVIDIA. También están las GPU de Intel -las ARC-, pero hablar de gaming en PC es hacerlo de esas dos grandes. NVIDIA tiene una significativa mejora debido a la potencia bruta de sus tarjetas gráficas y a su tecnología basada en la IA. AMD se está poniendo las pilas en este sentido, pero hace 30 años, las cosas eran muy diferentes. NVIDIA acababa de nacer y su gran rival no era AMD -existía, pero hacían procesadores como Intel-, sino las tarjetas gráficas de ATI y las de la empresa 3dfx. Puede que el nombre de ATI te suene porque vivieras esa época, pero también es posible que lo hayas olvidado o que no lo conocieras en absoluto. Esto es de lo más normal, ya que la marca como tal desapareció en 2010. Pero las cosas podrían haber sido muy diferentes. Tanto que, según el autor del fantástico libro ‘The NVIDIA Way’ de Tae Kim, si el presidente de la ATI de entonces hubiese sido Jensen Huang de NVIDIA, la que habría desaparecido habría sido… NVIDIA. Veamos qué pasó con ATI, la empresa que pudo comerse el mercado de las tarjetas gráficas y se esfumó, dejando un legado muy, muy importante. Los inicios y el mercado OEM En la década de los 90, el nombre de ATI era sinónimo de innovación en el segmento de las tarjetas gráficas. La empresa fue fundada en 1985 con el nombre de Array Technology INC, pero un mes después cambiaron el ‘Technology’ por ‘Tecnologies’. Esto tenía mucho sentido, ya que la empresa canadiense se dio cuenta bastante pronto de que había que diversificarse en el creciente mercado de la computación. En Xataka El PC ha cumplido 40 años: cómo un ordenador que nació a contracorriente puso la primera piedra de la plataforma más exitosa de la historia Empezaron, sobre todo, como fabricante de tarjetas gráficas integradas para fabricantes como IBM o Commodore, siendo las tarjetas EGA Wonder y VGA Wonder sus dos productos principales. Se trataba de un hardware enfocado al procesamiento de texto e imágenes rudimentarias en 2D, pero pronto apostaron por aportar algo revolucionario: en la línea ATI Wonder integraron un procesador de audio Sound Blaster. La competencia también añadía mejoras en el procesamiento de gráficos, pero generación tras generación, ATI demostraba que eran capaces de aportar características rompedoras en sus GPU. En 1991, ATI presentó las GPU Mach 8, mejorando el procesado de imágenes 2D y sólo un año después la Mach 32 que combinaba la tecnología de las propias Mach y Wonder en una sola tarjeta. Lo más importante es que estas Mach fueron sus primeras tarjetas gráficas que podían procesar información y gráficos sin necesidad de una CPU que estuviera apoyando. La compañía siguió innovando, mejorando no sólo la potencia de sus tarjetas gráficas, sino también incorporando chips gráficos que permitían sintonizar una televisión (las All-in-Wonder), compatibilidad con el puerto AGP y, sobre todo, aceleradores 3D para competir contra las VooDoo de la compañía 3dfx. Pelea salvaje por el 3D NVIDIA llegó a la fiesta en abril de 1993 de la mano de Jensen Huang, un ingeniero y diseñador de microprocesadores que trabajaba en AMD. La compañía llegó con la idea de que el futuro era la aceleración basada en una unidad gráfica, pero realmente en este momento pintaba más bien poco en el segmento de las tarjetas gráficas. A mediados de los 90, lo que estaba en boca de todos era… el 3D. Aunque había quien pensaba que era una moda pasajera y que los juegos en 2D seguirían siendo el futuro (sobre todo debido al grado de excelencia alcanzado en la generación de los 16 bits, la llegada de máquinas como la SEGA Saturn y, sobre todo, la primera PlayStation, demostraron que el 3D era la tecnología que iba a dominar. Pero aunque estas máquinas apostaban por el 3D, no fueron ellas las que despertaron la fiebre por esta tecnología, sino algo que sigue estando muy de moda: ‘Doom’. El videojuego creado por Carmack y Romero en 1993 no sólo es inmortal, sino que inició en la época una oleada de clones, algunos de ellos con muchísima calidad. En Xataka “Nos dio seis meses de vida”: cuando NVIDIA estuvo a punto de quebrar y SEGA se convirtió en su único salvador Vale, ¿no estábamos con la historia de ATI? Sí, pero esto es importante porque en esta época ATI, aunque tenía capacidades 3D en las Mach 64, no era la reina. Quien partía el bacalao era 3dfx, y lo hacía gracias a otro juego de Carmack y Romero: ‘Quake’. Fue un juego rompedor que hacía que ‘Doom’ y ‘Doom 2’ quedaran como anticuados gracias a un magistral uso de los polígonos. All in Wonder El motor del juego, llamado Quake Engine o Id tech 2, formó una dupla perfecta con las tarjetas aceleradoras de 3dfx. Para competir, ATI lanzó las tarjetas 3D Rage, con diferentes versiones a lo largo de los años, en una carrera po

AMD y NVIDIA. También están las GPU de Intel -las ARC-, pero hablar de gaming en PC es hacerlo de esas dos grandes. NVIDIA tiene una significativa mejora debido a la potencia bruta de sus tarjetas gráficas y a su tecnología basada en la IA. AMD se está poniendo las pilas en este sentido, pero hace 30 años, las cosas eran muy diferentes.

NVIDIA acababa de nacer y su gran rival no era AMD -existía, pero hacían procesadores como Intel-, sino las tarjetas gráficas de ATI y las de la empresa 3dfx. Puede que el nombre de ATI te suene porque vivieras esa época, pero también es posible que lo hayas olvidado o que no lo conocieras en absoluto. Esto es de lo más normal, ya que la marca como tal desapareció en 2010.

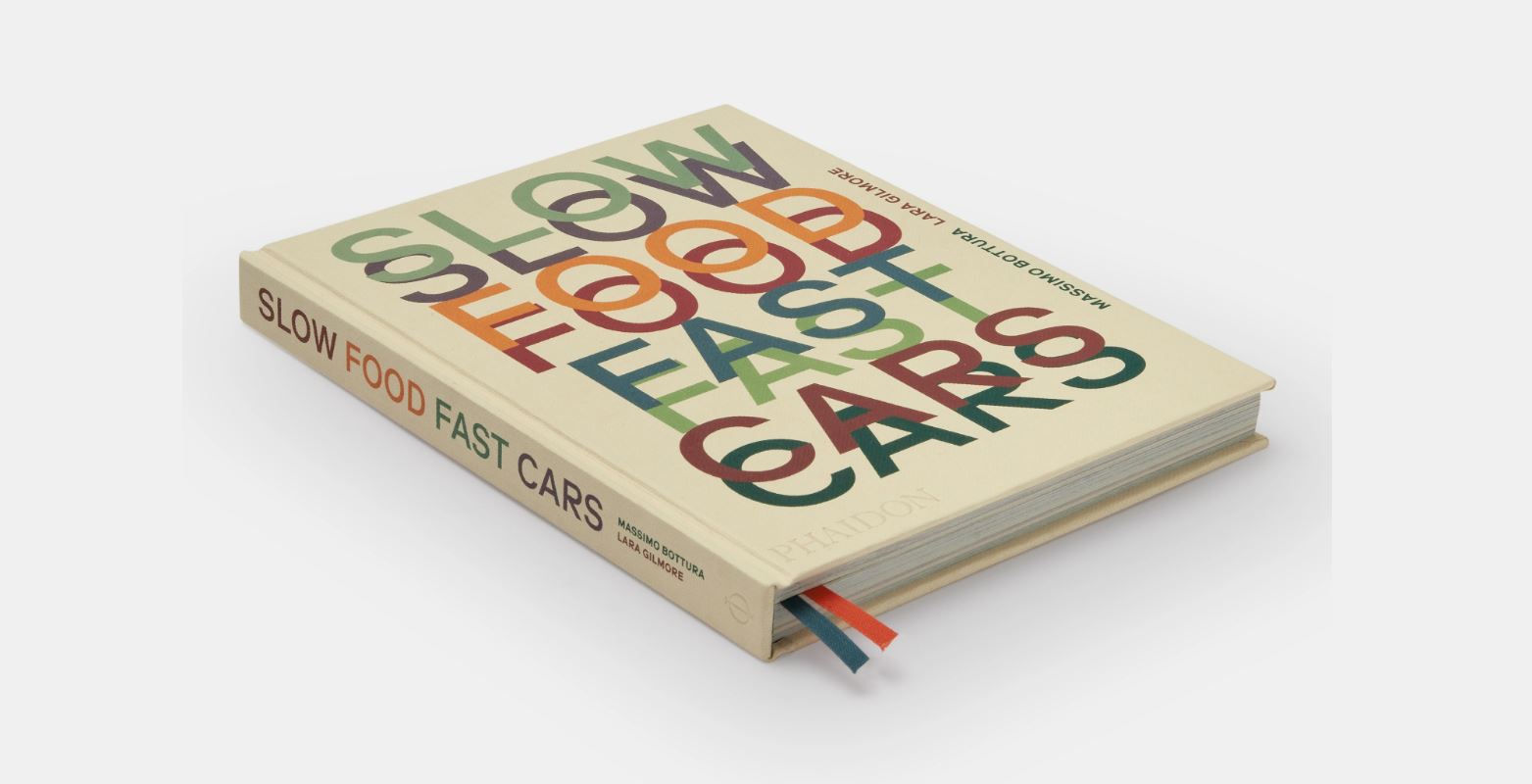

Pero las cosas podrían haber sido muy diferentes. Tanto que, según el autor del fantástico libro ‘The NVIDIA Way’ de Tae Kim, si el presidente de la ATI de entonces hubiese sido Jensen Huang de NVIDIA, la que habría desaparecido habría sido… NVIDIA. Veamos qué pasó con ATI, la empresa que pudo comerse el mercado de las tarjetas gráficas y se esfumó, dejando un legado muy, muy importante.

Los inicios y el mercado OEM

En la década de los 90, el nombre de ATI era sinónimo de innovación en el segmento de las tarjetas gráficas. La empresa fue fundada en 1985 con el nombre de Array Technology INC, pero un mes después cambiaron el ‘Technology’ por ‘Tecnologies’. Esto tenía mucho sentido, ya que la empresa canadiense se dio cuenta bastante pronto de que había que diversificarse en el creciente mercado de la computación.

Empezaron, sobre todo, como fabricante de tarjetas gráficas integradas para fabricantes como IBM o Commodore, siendo las tarjetas EGA Wonder y VGA Wonder sus dos productos principales. Se trataba de un hardware enfocado al procesamiento de texto e imágenes rudimentarias en 2D, pero pronto apostaron por aportar algo revolucionario: en la línea ATI Wonder integraron un procesador de audio Sound Blaster.

La competencia también añadía mejoras en el procesamiento de gráficos, pero generación tras generación, ATI demostraba que eran capaces de aportar características rompedoras en sus GPU. En 1991, ATI presentó las GPU Mach 8, mejorando el procesado de imágenes 2D y sólo un año después la Mach 32 que combinaba la tecnología de las propias Mach y Wonder en una sola tarjeta.

Lo más importante es que estas Mach fueron sus primeras tarjetas gráficas que podían procesar información y gráficos sin necesidad de una CPU que estuviera apoyando. La compañía siguió innovando, mejorando no sólo la potencia de sus tarjetas gráficas, sino también incorporando chips gráficos que permitían sintonizar una televisión (las All-in-Wonder), compatibilidad con el puerto AGP y, sobre todo, aceleradores 3D para competir contra las VooDoo de la compañía 3dfx.

Pelea salvaje por el 3D

NVIDIA llegó a la fiesta en abril de 1993 de la mano de Jensen Huang, un ingeniero y diseñador de microprocesadores que trabajaba en AMD. La compañía llegó con la idea de que el futuro era la aceleración basada en una unidad gráfica, pero realmente en este momento pintaba más bien poco en el segmento de las tarjetas gráficas.

A mediados de los 90, lo que estaba en boca de todos era… el 3D. Aunque había quien pensaba que era una moda pasajera y que los juegos en 2D seguirían siendo el futuro (sobre todo debido al grado de excelencia alcanzado en la generación de los 16 bits, la llegada de máquinas como la SEGA Saturn y, sobre todo, la primera PlayStation, demostraron que el 3D era la tecnología que iba a dominar.

Pero aunque estas máquinas apostaban por el 3D, no fueron ellas las que despertaron la fiebre por esta tecnología, sino algo que sigue estando muy de moda: ‘Doom’. El videojuego creado por Carmack y Romero en 1993 no sólo es inmortal, sino que inició en la época una oleada de clones, algunos de ellos con muchísima calidad.

Vale, ¿no estábamos con la historia de ATI? Sí, pero esto es importante porque en esta época ATI, aunque tenía capacidades 3D en las Mach 64, no era la reina. Quien partía el bacalao era 3dfx, y lo hacía gracias a otro juego de Carmack y Romero: ‘Quake’. Fue un juego rompedor que hacía que ‘Doom’ y ‘Doom 2’ quedaran como anticuados gracias a un magistral uso de los polígonos.

All in Wonder

All in Wonder

El motor del juego, llamado Quake Engine o Id tech 2, formó una dupla perfecta con las tarjetas aceleradoras de 3dfx. Para competir, ATI lanzó las tarjetas 3D Rage, con diferentes versiones a lo largo de los años, en una carrera por superar a 3dfx y a las primeras GPU de NVIDIA. También llevo a decisiones curiosas, como el lanzamiento en 1999 de la ATI Rage Fury MAXX (y nos quejamos de algunos nombres actuales).

Como las Rage 128 Pro de ATI no eran capaces de vencer a las últimas VooDoo de 3dfx y NVIDIA ya empezaba a mostrar músculo, la compañía creó una GPU que combinaba en un solo PCB dos chips gráficos de la Rage 128 Pro. Fue un error, ya que Windows 98 y ME (que fue un sistema operativo horroroso) eran compatibles, pero Windows 2000 estaba a la vuelta de la esquina y Microsoft no soportaba dos GPU en ese modo.

Radeon, el apogeo de ATI

Nos plantamos en los 2000. El reinado de 3dfx fue efímero debido a que NVIDIA se quedó con mucha de su tecnología y entraron en bancarrota, quedando en el mercado únicamente NVIDIA Y ATI como marcas por las que apostar tanto para jugar como para estaciones de trabajo en 3D.

Fue una época apasionante en la que las dos compañías se turnaban para lanzar productos realmente innovadores, una lucha por la potencia que se iba superando con lanzamientos anuales y con las dos compañías siendo pioneras en una u otra cosa. En el 2000, ATI lanzó la marca Radeon y en su haber tiene que fue la primera compatible con la API DirectX9.

Tarjetas como la Radeon 9700 Pro se convirtieron en un referente en el mercado, pero además, la compañía logró acuerdos con fabricantes como Dell o HP para que sus GPU estuvieran integradas en sus equipos. También se posicionaron bien en el segmento de los portátiles (en auge en aquel momento) y en el de las consolas.

ATI pudo aplastar a NVIDIA, pero les faltó ambición

Volvamos un momento a DirectX 9. Por problemas legales con Microsoft, NVIDIA no pudo acceder a las especificaciones técnicas de la API, por lo que tuvieron que diseñar su chip NV30 prácticamente a ciegas. Corría el año 2003 y ATI estaba en todo su esplendor gracias a las Radeon. NVIDIA lanzó varias GPU ese año para intentar adaptarse lo antes posible al estándar, pero las cosas no iban bien.

NVIDIA había absorbido buena parte de la fuerza laboral de 3dfx, así como algunas de sus tecnologías (SLI, por ejemplo), pero Huang se dio cuenta de que los ingenieros de su compañía y los recién llegados desde 3dfx no trabajaban bien juntos. Todo esto fue un cóctel que casi termina con la bancarrota de la compañía.

Una ATI Radeon 9700 Pro

Una ATI Radeon 9700 Pro

Esto es algo que se cuenta en ‘The NVIDIA Way’, pero lo más interesante de toda esta historia es que el futuro de NVIDIA estuvo en las manos… de ATI. El autor, en una reciente entrevista, comentó que Dwight Diercks, líder de ingeniería de software de NVIDIA, le dijo que fue un momento crítico:

“Si ATI hubiese sido más despiadada en el aspecto comercial, podría haber dado el último empujón a NVIDIA hacia la bancarrota. Con el Radeon 3000 y, en particular, con el Radeon 9700 tenían márgenes de beneficios muy altos. Si ATI hubiese reducido los precios, habrían aplastado a una NVIDIA que apenas ganaba dinero con las NV30 a 399 dólares.”.

La clave de esta historia es que Dierks afirma que “si Jensen hubiese estado al mando de ATI, habría llevado a la bancarrota a NVIDIA porque habría sabido perfectamente qué hacer”.

Peleando por las consolas

Aunque había problemas, NVIDIA logró el acuerdo con Microsoft para fabricar la GPU de la primera Xbox, pero ATI no se quedó de brazos cruzados y logró asociarse con Nintendo (gracias a que compró la empresa ArtX) para diseñar el procesador gráfico de GameCube.

GameCube fue muy potente, lo que demostraba que ATI también podía plantar cara en ese mercado, pero además, también consiguieron contratos para el chip Xbox 360 y el premio gordo (por las ventas que tuvo la consola): Wii. NVIDIA, por su parte, fue la que proporcionó la GPU de PlayStation 3.

El frontal de GameCube nos recuerda la asociación con ATI

El frontal de GameCube nos recuerda la asociación con ATI

Ahí ya estamos en una situación completamente diferente porque, como decimos, ATI no aprovechó su momento y Nvidia, con sus nuevas GeForce, las tecnologías de 3dfx, el acuerdo con Sony para el procesador de gráficos RSDX y otros acuerdos comerciales, empezó a despuntar. De hecho, una de las adquisiciones fue ULI Electronics, empresa que suministraba piezas a ATI.

Llegó AMD y desapareció ATI

A pesar de sus logros en años pasaros, ATI empezó a enfrentar dificultades debido a que NVIDIA se había puesto las pilas y la competencia era cada vez más cara. Los márgenes de beneficios se reducían porque NVIDIA estaba apretando fuerte y, así, entró en escena otro gigante de la industria: AMD.

En 2006, AMD adquirió ATI por 5.400 millones de dólares y, durante unos años, las tarjetas de la compañía pasaron a llamarse ATI AMD Radeon. Se deshicieron de algo del lastre de ATI, vendieron tecnologías y empezaron una profunda restructuración que culminó en el año 2010, cuando eliminaron definitivamente el nombre de ATI.

De las últimas sin el nombre de AMD

De las últimas sin el nombre de AMD

Lo peor es que la situación que vivieron desde entonces es muy similar a la actual: GPU relegadas a la gama media con un muy buen rendimiento, pero superadas por la contrapartida de NVIDIA. Eran incapaces de plantar cara a una NVIDIA que dominaba el mercado más exigente de PC y daba la sensación de que ATI lanzaba buenos productos, sí, peor para “contestar” a los que lanzaba NVIDIA. Y, aun así, sin poder jugar en el terreno de la gama alta.

El precio era muy competitivo, pero el rendimiento alejaba a compradores que, en aquellos años, querían disfrutar de títulos tan exigentes como ‘Crysis’ en sus PC.

Legado

Podemos decir que, si bien en los 90 y primeros años de los 2000, ATI protagonizó buenas batallas en el mundillo del PC y las consolas, la segunda mitad de los primeros años del siglo XXI se les hizo cuesta arriba. NVIDIA no sólo empujaba fuerte en potencia, sino que seguía desarrollando nuevas tecnologías como los núcleos CUDA o PhysX para calcular físicas (recuerdo que ‘Batman Arkham Asylum’ era un juego diferente visualmente cuando se activaba este motor de físicas). Y ATI no pudo competir.

Sin embargo, es una compañía que no merece ser olvidada por todo lo aportó a la industria y que sigue viva, en cierto modo. La compra de ATI por parte de AMD permitió que la compañía desarrollara sus APU, las unidades que, en un solo chip, combinaban una CPU y una GPU. De hecho, eso es lo que mejor se le daba a AMD cuando Intel y NVIDIA les pasaron por encima hace una década, y es algo que siguen trabajando a la perfección.

No en vano, los SoC de PS5 y Xbox Series tienen tecnologías de AMD, así como los de la anterior generación de consolas (excepto Switch, con corazón Tegra de NVIDIA). Actualmente, los procesadores Ryzen para portátiles que integran gráficos Radeon otorgan un rendimiento genial, Steam Deck también es una muestra de ello, y lo más curioso es que una de las tecnologías de las que AMD se desprendió cuando compró ATI fue… Imageon.

Se vendió a Qualcomm, compañía que lo renombró a Adreno para crear los SoC que utilizan millones de móviles en la actualidad. Por tanto, aunque ATI muriera hace 15 años, sus tecnologías y lo que crearon en su momento siguen muy presentes en la actualidad.

Imágenes | Xataka, Daniele Napolitano, Craig Wyzik from Olympia, Swaaye, Adam Snyder

En Xataka | Qué fue de ‘Turbo’, el singular botón que tenían casi todos los PC en la década de los 90

-

La noticia

Qué fue de ATI: de mirar cara a cara a NVIDIA a acabar devorada y olvidada por la industria de la tecnología

fue publicada originalmente en

Xataka

por

Alejandro Alcolea

.