NumSpot réagit aux actualités liées à DeepSeek

NumSpot réagit aux actualités liées à DeepSeek - Points de Vue

En lien avec les récentes actualités liées à DeepSeek AI, et notamment l'attaque subie par l'IA chinoise en milieu de semaine dernière et ayant exposé plus d'un million de données, le commentaire de la part de Patrick Laurence-Frings, Directeur général de NumSpot.

« L'arrivée sur le devant de la scène tech de DeepSeek AI il y a quelques jours, suivie de l'annonce d'une compromission sur un peu plus d'un million de données de sa base, sont deux actualités qui montrent à quel point l'utilisation de solutions numériques non-européennes représente un risque majeur pour les données.

Sans remettre en question les avancées que ces technologies permettent sur le marché en termes d'accélération de la compétitivité, il faut avoir conscience du risque que présente leur utilisation par une entreprise, sans précautions supplémentaires. En effet, les modèles d'IA dits « généralistes », comme celui de DeepSeek AI ou ChatGPT, posent quatre types de risques :

Des risques opérationnels : recourir à un modèle dont on ne connaît pas précisément les modalités d'entraînement peut mener à des contenus de mauvaise qualité, incluant des biais et des hallucinations ;

Des risques de souveraineté : Le recours à un outil hébergé sur des solutions non-souveraines, hébergées auprès d'acteurs non européens, expose à la réquisition des données dans le cadre de législations comme le Cloud Act et le FISA pour les Etats-Unis, des lois chinoises pour DeepSeek, et à la non-conformité par rapport au RGPD.

Des risques juridiques : Les informations saisies dans un outil d'IA « généraliste » risquent de se retrouver dans le domaine public, exposant l'entreprise à des risques de confidentialité et de compétitivité, si les concurrents accèdent à des données sur sa stratégie commerciale par exemple.

Des risques cyber : En exploitant les vulnérabilités de ces solutions, des hackers peuvent causer des dégâts considérables en influençant les décisions prises par l'IA, en volant des données privées ou en provoquant des incidents délibérément.

Pour éviter d'être confronté à ces risques, les entreprises doivent privilégier des IA dites « de confiance ». C'est ce que la Commission Européenne a établi comme qualificatif pour les IA qui respectent sept principes fondamentaux, parmi lesquels le respect de la vie privée, la gouvernance des données, la robustesse technique de leur infrastructure, et le niveau de sécurité. Or, la plupart des solutions d'IA, qui nécessitent par définition des ressources de calcul importantes, fonctionnent en général sur des environnements de cloud public et nourrissent leurs modèles avec des données non-anonymisées, afin d'en tirer le plus d'intelligence.

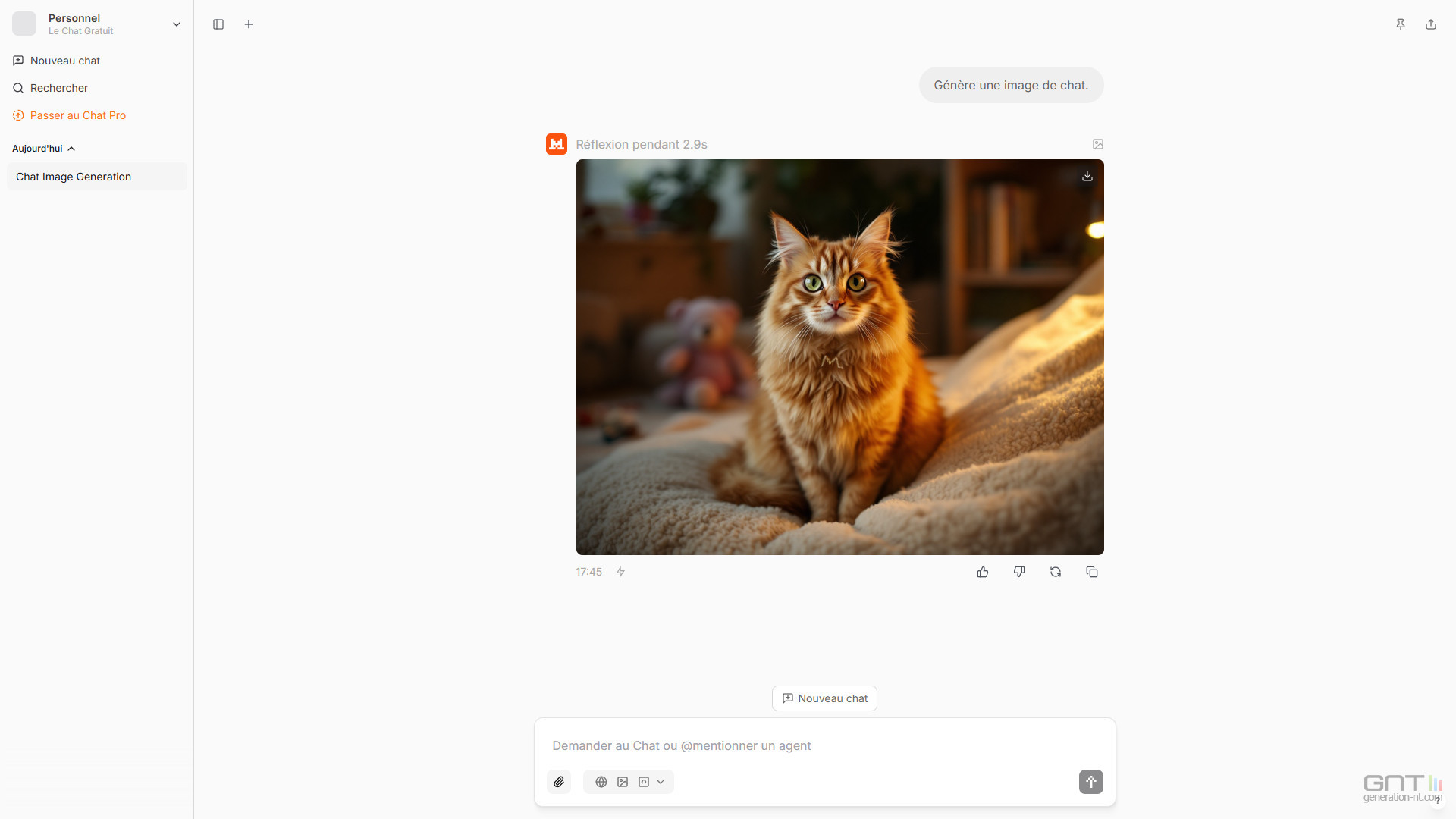

Cela explique pourquoi les acteurs des secteurs stratégiques et sensibles ont dû renoncer pour le moment aux bénéfices de l'IA pour des questions de confidentialité des données. Pour ces secteurs, il est indispensable d'opter pour un cloud souverain et de confiance pour ne pas s'exposer aux lois extraterritoriales, d'héberger les données dans des clouds 100% souverains, voire qualifiés SecNumCloud et HDS en fonction de la sensibilité des données, et d'éviter toute fuite des données. Des alternatives européennes sérieuses existent déjà, notamment dans le domaine de l'open source, telles que Mistral AI ou LightOn en France, qui sont disponibles sur des infrastructures clouds de confiance. »

.jpg)

![Flexibilité : la CRE compte sur le marché [compte-rendu]](https://www.greenunivers.com/wp-content/uploads/2025/02/image-6.png)